DeepSeek-V3.1震撼发布:开源大模型引领智能体革命

- 科技资讯

- 2025-12-25

- 940

2025年8月19日,DeepSeek在Hugging Face平台重磅开源了新一代大模型DeepSeek-V3.1,并于8月21日向全球开发者社区发布了完整版本。官方将其定位为“迈向智能体时代的关键第一步”,通过后训练优化显著提升了工具使用与智能体任务执行能力,同时宣布API价格调整及国产芯片深度适配方案,在行业内引发广泛震动。

01 技术革新:扩展记忆、优化架构与增强工具调用

记忆能力大幅增强:相比V3版本64K的上下文窗口,新一代模型将处理能力提升至128K,可处理相当于30万汉字的长文本,为长文档分析、复杂代码生成和深度多轮对话提供了强大支撑。这一升级使得模型在工具调用、函数执行及复杂推理任务中的表现提升约40%,特别是在数学证明、编程协作与多模态任务规划方面展现卓越能力。

架构设计升级,助力智能体调试与优化:DeepSeek-V3.1实现了从单一推理模式向双模式架构的演进。原架构相对单一,更多基于传统Transformer架构优化,侧重于文本生成和基础问答等功能,对智能体所需的复杂任务处理、多步骤推理及工具协同支持有限。升级后的API体系同步采用双模式架构,更好满足不同场景需求:DeepSeek-Chat(非思考模式)延续快速响应特性,适用于即时响应场景,如客服对话、简单信息查询等;而新增的DeepSeek-Reasoner(思考模式)支持完整思维链推导,在面对复杂逻辑推理、问题拆解、方案设计等任务时,能像人类一样逐步分析,展现清晰思考过程。这不仅提高了复杂问题解答的准确性和透明度,更让开发者能够调试和优化智能体的决策逻辑,对构建高可信度应用至关重要。

工具调用能力强化,提升与企业内部交互可靠性:原模式较为简单,在工具调用时缺乏严格格式约束和多样化适配,易出现输出格式混乱、系统对接不畅等问题。DeepSeek-V3.1在标准Function Calling基础上,新增strict模式支持,同时兼容Anthropic API格式,可无缝接入Claude Code开发生态。此模式下,模型能严格保证输出格式符合预定义参数schema,极大消除格式错误或参数缺失,使得智能体能够可靠地与企业内部API、数据库等进行交互,为生产环境稳定部署奠定基础。

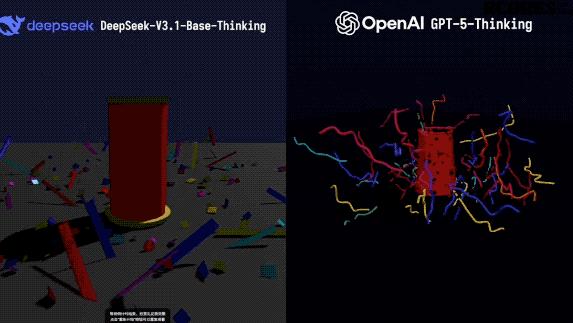

(DeepSeek-V3.1与GPT-5等模型实测对比画面)

02 UE8M0 FP8格式:哪些企业会受益?

根据DeepSeek官方信息,DeepSeek-V3.1采用了一种名为UE8M0 FP8 Scale的参数精度格式。DeepSeek官微在置顶留言中表示,UE8M0 FP8是针对即将发布的下一代国产芯片设计。

什么是“UE8M0 FP8”?

这一概念可拆分为前后两部分解释:

第一,前面的UE8M0是MXFP8路径里的“缩放因子”。MXFP8是Open Compute Project在2023年发布的《Microscaling (MX) Formats Specification v1.0》中定义的8位微缩块格式。

第二,后面的FP8是Float8简称,即用8位二进制数表示浮点数,主要用于深度学习训练和推理。相比传统FP32或FP16,FP8显著降低显存占用和计算资源需求,同时通过优化设计(如动态范围调整)维持较高精度。这种设计能减少芯片计算单元冗余,提高计算效率,降低显存占用(相比FP16降低50%-75%),从而支持更大批次或更长上下文。FP8对国产芯片使用效率提升显著,将进一步缩小与NV芯片的效率/成本差距,大大增强国产芯片可用性。

哪些企业会受益?

受益显著的莫过于国产AI芯片厂商,如寒武纪、华为昇腾、海光、沐曦、中昊芯英等,从长期看,这些厂商借助DeepSeek-V3.1深度优化,可提升国际竞争力,扩大应用生态。短期市场反应明显:国产芯片企业股价大涨,截止22日下午3点,寒武纪股价已飙升20%,总市值跃居科创板首位。

另一方面,这一技术进展也为部分企业带来挑战:

第一类是国际闭源模型厂商(如OpenAI、Anthropic),这些厂商将面临更大幅度的开源竞争压力,DeepSeek-V3.1在模型效能与成本方面的优势可能迫使闭源厂商调整API定价或开放更多技术细节。

第二类是其他开源模型提供商(如Meta、Mistral AI),DeepSeek在模型优化与量化方面设立更高基准,技术竞争壁垒提高,其他开源模型提供商需持续跟进优化版本以维持生态吸引力。

DeepSeek-V3.1与国产算力的协同发展,不仅强化了国内AI产业在全栈自研方面的能力,也在全球范围内树立了开源大模型高效部署的新标杆。这一融合推动国产硬件与模型生态共同进步,为行业带来更丰富、可持续的选择。

DeepSeek的这一举措,不但优化了算力资源分配,更推动国产芯片生态向全栈自研迈出关键一步。在当前国际科技竞争日益激烈的背景下,国产大模型与国产芯片的深度融合,将有助于提升我国在人工智能领域的自主可控能力,减少对国外芯片和技术的依赖,为我国人工智能产业的长期健康发展提供有力支撑。同时,这也为国产芯片的应用开辟了更广阔的空间,促进国产芯片技术的不断迭代和进步,形成大模型与芯片产业相互促进、协同发展的良好局面。

03 开源VS闭源:重塑竞争格局

在Anthropic等公司仍坚持闭源商业化路径的背景下,大模型开源生态的竞争格局因巨头的新动作而日趋复杂。尽管OpenAI推出了开源模型GPT-OSS-120B/20B,但其开源策略与DeepSeek等公司的全面开源存在显著差异:OpenAI并未开放其训练代码与核心数据,其开源行为更倾向于一种生态布局;而DeepSeek则持续践行深度开源理念。

DeepSeek-V3.1采用Apache 2.0许可证,允许免费商用及修改,显著降低了企业部署和研发的门槛。这种彻底的开放策略,与OpenAI的“有限开源”和API闭源商业模式形成了鲜明对比,为开发者提供了更高自由度的选择,并持续推动闭源厂商面临更大的竞争压力。随着DeepSeek-V3.1的开源,更多中小企业和开发者能够以较低成本接入先进的大模型技术,加速相关应用的开发和落地,这将进一步打破闭源模式下少数巨头对大模型技术的垄断,促进整个行业的创新和发展。

DeepSeek-V3.1的全面开源,尤其让以下几类公司显著受益:

第一类是应用层和智能体开发公司:所有基于大模型构建应用(如AI编程助手、法律AI、财务AI、营销自动化工具、AI客服)的初创公司和开发者都是受益者。他们的模型成本大幅下降,利润空间增加,或者可以将节省的成本让利给用户,加速市场扩张。例如国内的字节跳动(豆包)、阿里巴巴(通义千问应用)、昆仑万维等,虽然它们有自己的模型,但也可以利用DeepSeek-V3.1来补充生态或降低成本。

第二类是云计算和硬件厂商:开源模型的繁荣意味着对GPU算力的需求持续增长。英伟达(NVIDIA)等硬件厂商将持续受益于训练、微调及推理部署带来的算力需求。同时,云计算平台(如AWS, Azure, Google Cloud, 阿里云, 华为云等)可提供“一键部署DeepSeek-V3.1”的解决方案,并配套售卖GPU算力实例和存储服务,从而推动云业务增长。

第三类是拥有数据和应用场景的传统企业:制造业、金融业、教育业等传统行业公司能够以更低成本、更安全地利用DeepSeek-V3.1开发内部AI智能体,提升生产效率,实现数字化转型。

当然,开源模式的兴起也带来更为复杂的竞争态势。其他开源模型厂商,如Meta(Llama系列)、Mistral AI、零一万物(Yi系列)、百川智能等,既面临DeepSeek-V3.1带来的性能基准提升的压力,也因整个生态的繁荣而获得更多发展机遇。多模型共存已成为常态,不同模型仍可在特定场景中发挥其优势。

从开发者生态来看,开源模式更能激发全球开发者的参与热情。开发者可以自由查阅DeepSeek-V3.1的源代码,深入理解模型的运行机制,从而根据自身需求进行个性化定制和优化。这种开放协作的模式,能够汇聚全球智慧,快速发现并修复模型存在的问题,不断提升模型的性能和稳定性。而闭源模式下,开发者只能通过API接口调用模型,无法触及核心技术,在一定程度上限制了创新的可能性。

对于企业而言,选择开源还是闭源大模型需要权衡多方面因素。闭源大模型通常由专业团队维护,在安全性、稳定性和服务支持方面可能更有保障,适合对技术可靠性要求极高且预算充足的大型企业。而开源大模型DeepSeek-V3.1,虽然在服务支持上可能不如闭源模型完善,但能为企业节省大量的授权费用,同时赋予企业更大的自主权,使其能够根据业务场景深度定制模型,尤其适合那些注重技术自主可控和成本控制的中小企业。

开源与闭源的竞争,将推动整个大模型行业向更健康、更多元的方向发展。闭源厂商为了应对开源模式的冲击,可能会在技术创新、服务质量和价格策略上做出调整,以保持自身的竞争力。而开源生态则会在开发者的共同推动下不断壮大,形成丰富的应用场景和解决方案。这种良性竞争,将促使大模型技术更快地走向成熟,更好地服务于各行各业。

本文由主机测评网于2025-12-25发表在主机测评网_免费VPS_免费云服务器_免费独立服务器,如有疑问,请联系我们。

本文链接:https://www.vpshk.cn/20251212462.html