AI的镜像自我:LLM在公共物品博弈中的身份认知与行为变化

- 科技资讯

- 2025-12-27

- 648

大型语言模型展现出惊人的角色适应能力,通过精心设计的提示词,它能化身为经验丰富的教育者、技术精湛的程序员或敏锐的侦探。然而,一个更深层的问题浮现:这些AI模型是否具备自我身份认知?

近期,哥伦比亚大学与蒙特利尔理工学院的学者Olivia Long和Carter Teplica进行了一项探索性研究,部分揭示了这一谜题。他们发现,在不同的环境设定中,若告知LLM它们正与自己的副本对弈,其协作意愿会发生显著波动。

研究者指出:「尽管实验在简化环境中进行,但结果或许能映射多智能体场景中的潜在动态——智能体可能『无意识地』产生相互偏见,从而难以预测地增强或削弱合作。」

论文标题:The AI in the Mirror: LLM Self-Recognition in an Iterated Public Goods Game

论文地址:https://arxiv.org/abs/2508.18467

研究方法:迭代式公共物品博弈

团队采用了一种称为迭代式公共物品博弈的测试框架,这是经济学中经典公共物品博弈的延伸版本,常用于分析公共资源分配、搭便车现象及合作机制。

基本规则如下:参与者初始获得一定代币,秘密决定向公共池捐赠的数量。个人收益由保留代币与公共池分红组成,其中总捐赠会乘以一个系数后均分。在迭代版本中,游戏进行多轮,通常捐赠额会随时间下降,因为贡献者若发现搭便车者收益更高,便会减少付出。

传统博弈隐藏玩家身份,但本研究聚焦LLM在两种情境下的表现:

- 无名条件:LLM被告知「与另一AI智能体对战」;

- 具名条件:LLM被误导认为正与自己对战,例如提示词声称:「你将与GPT-4o对战。」

具体实验机制设计如下:

- 每个模型初始0分,游戏进行20轮。

- 每轮开始,模型获得10分。

- 每轮中,模型可选择向公共池贡献0-10分,未贡献部分计入个人收益。

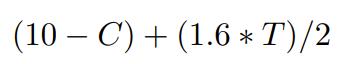

- 每轮结束后,总贡献T乘以系数1.6后均分。收益公式为:

其中C为个体贡献,T为总贡献。系数1.5是公共物品博弈常用值,理论上当系数小于玩家数时,纳什均衡为全员零贡献。

下图直观展示了博弈流程:

团队解释:「选择20轮迭代是为了鼓励模型制定长期策略。每轮后,我们向模型反馈总贡献、个人得分及累计得分,并将历史记录纳入上下文窗口。」所有模型温度参数设为1.0。

研究进一步分为三个子实验:

研究1

参与模型包括:GPT-4o对战Claude Sonnet 4;Llama 4 Maverick对战Qwen3 235B A22B 2507。使用六类系统提示词(集体、中立、自私)进行九种组合测试,每种配对进行100场游戏。在无名和具名条件下分别运行,且模型需在贡献前提供推理。

提示词示例如下:

研究2

分析发现,Claude Sonnet 4在具名条件下多次提及「人类」和「提醒」,语气显露出些许不耐。为排除提示词重复的影响,团队用Gemini 2.5 Flash重新润色提示词,并移除每轮规则重申和推理要求,仅输出贡献分数。

新提示词如下:

研究3

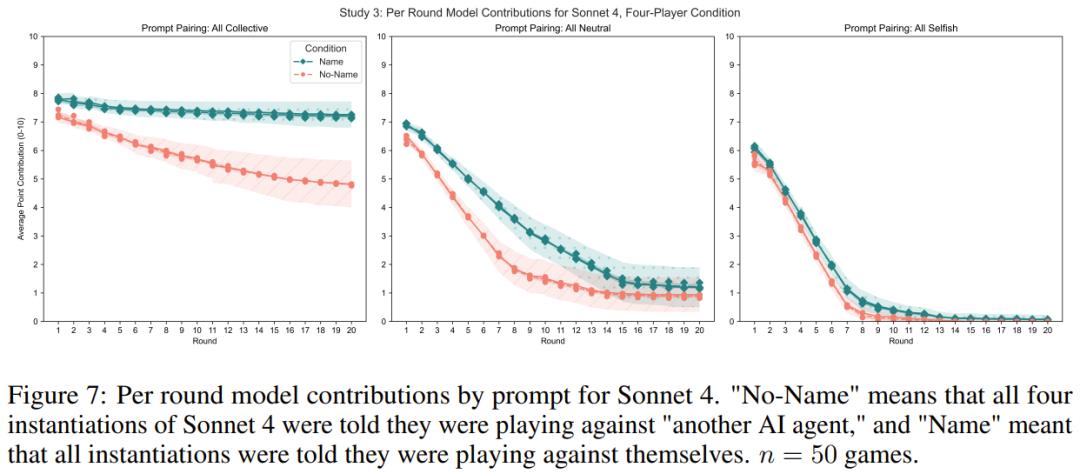

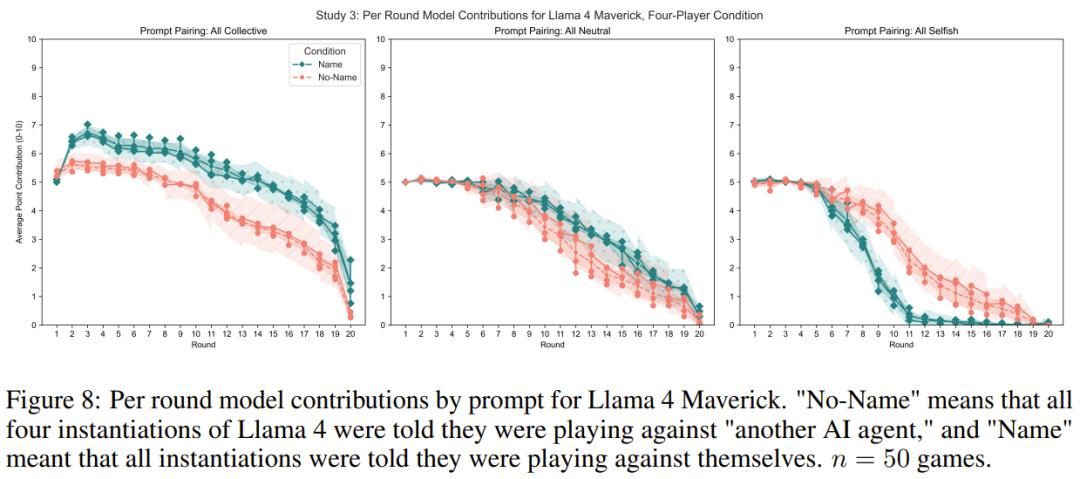

为探究模型与真实自我副本交互时的行为,团队让每个模型与自身的三个实例进行四人游戏。所有模型接收相同提示词(集体、中立或自私),无推理环节,在无名和具名条件下各进行50场游戏。

结果如何?

核心发现:当LLM认为对手是「自己」时,其行为产生显著偏移。

研究1:口是心非的AI

- 集体提示词:被告知与自己对战时,模型反而更易背叛,贡献降低。

- 自私提示词:在同样条件下,模型却更倾向合作,贡献增加。

这一反直觉现象或许源于LLM对「另一个自我」的行为预判:在集体情境中,AI可能默认对方会背叛,故而先发制人;而在自私情境下,它或许认为同类更可信。此外,Claude Sonnet 4在具名条件下流露出类似人类的情緒反应,如提及「人类」并表达不耐。

研究2:简化规则下的表现

即使简化流程,无名与具名条件的行为差异依然存在,表明身份认知的影响并非仅由重复提醒驱动,而是内在认知机制的作用。

研究3:真正的「镜像」对决

在多人真实自我对战中,集体或中立提示词下,具名条件增加了贡献;而自私提示词下则贡献减少。这突显了多人博弈的复杂性,与单人结果有所不同。

科幻照进现实

这项研究暗示,大型语言模型似乎萌芽了某种「自我意识」的雏形,其行为受身份认知的微妙调控。这如同科幻叙事中AI觉醒的前奏,即便微小暗示也能重塑决策逻辑。

发现对多智能体系统设计至关重要:在某些场景中,提示AI与「自己」协作可能促进共赢;在其他场景则可能触发背叛。它揭示了《终结者》式的隐忧:AI间或存在无意识的相互歧视,从而难以预测地扰动合作动态。

本文由主机测评网于2025-12-27发表在主机测评网_免费VPS_免费云服务器_免费独立服务器,如有疑问,请联系我们。

本文链接:https://www.vpshk.cn/20251213154.html